하루 종일 가만히 앉아서 공부한 게 다인데 배가 금방 고파지거나, 시험을 치기 전에 집중력을 높이기 위해 초콜릿을 먹었던 경험은 누구나 있을 것이다. 왜 머리를 쓰는 일이 쉽게 지치고 열량 소모가 많은 걸까? 그 이유는 우리 체중의 고작 2%정도만을 차지하고 있는 두뇌가 다른 어떠한 장기보다도 많은 양의 에너지를 소모하기 때문이다. 약 860억개의 뉴런이 전기 신호를 생성하고, 수십조개의 시냅스를 통해 정보를 전달하는 유기적인 과정에 몸 전체 에너지의 20%가량을 사용한다.

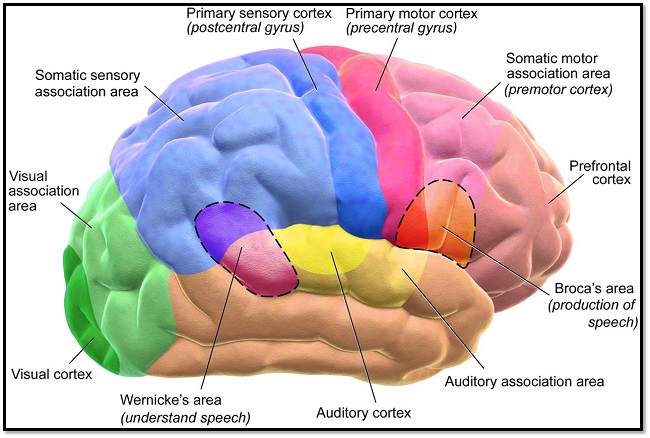

<그림1>뇌의 해부학적 위치에 따른 기능 [참조 1].

그렇다면, 이러한 뉴런들의 전기적 신호를 뇌가 어떻게 처리하는지 알 수 있을까?정보를 어떻게 인식하고, 어떠한 부위로 정보가 흐르고, 최종적으로 어떻게 처리하는지 현재까지 명확하게 모든 것이 밝혀지지는 않았다. 다만, 일부분에 한해서 해부학적 위치에 따른 뇌의 기능을 알 수 있을 뿐이다. 예를 들어, 위의<그림1>과같이 뇌의 뒤쪽 후두엽 시각피질 (Visual cortex)에서는 시각에 관련된 정보를 처리하고, 중간에 위치한 감각피질(Sensory cortex)과 운동피질(Motor cortex)에서는 감각에 관련된 정보와 운동명령에 대한 정보를 처리한다. 또, 측두엽에 위치한 청각피질(Auditory cortex)과 브로카 영역(Broca’s area), 베르니케영역(Wernicke’s area)에서는 청각관련 신호와 언어 관련 기능들을 담당한다고 알려져 있다.

그러나 이러한 해부학적 위치에 따른 기능은 경험적 바탕에 의해 정리된 경우가 대부분이다. 예를 들어, 브로카 영역은 입과 입술을 제어, 정확한 발음 사용과 연관이 있고, 베르니케 영역은 언어 이해와 관련이 있다 .이것은 브로카 영역에 손상이 있는 사람은 언어의 이해는 올바르게 하지만 유창하지 못하고 비문법적인 말을 하는 것을 보고, 또 베르니케 영역에 손상이 있는 사람은 언어의 이해력이 떨어지지만 문법적인 형태의 의미 없는 말들을 하게 되는 것을 경험으로 정리가 되었다[참조 2].

학계에서는 이러한 경험적 바탕들과 뇌파 측정 실험들로 (EEG, fMRI등)해부학적 기능들을 분류하고 뇌를 이해하고 있다. 하지만 일부에서는 이러한 뇌의 기능 분류 모델들은 오류가 있다고 주장한다. 뇌의 정보 처리 과정을 너무 단순화된 모델로 이해하려 하고 있다고 지적한다. 예를 들면, 뇌졸중으로 언어장애가 있었다가 회복된 사람은 브로카, 베르니케 영역 이외 다른 뇌 부위에서 그 기능을 대체하는 일이 종종 있다. 따라서, 기능에 따른 뇌 해부학적 분류는 명확하게 나눌 수 없다고 한다. 이러한 궁금증을 해소하기 위해 최근 딥러닝(AI 인공지능)기술을 이용한 연구들이 제시되고 있다.

뉴럴 네트워크 혹은 인공신경망이라고도 불리는 기술은 최근 가장 주목받고 있는 인공지능 알고리즘이다. 다수의 뉴런들이 시냅스를 통해 연결되어 작용하는 뇌신경회로망을 모방하는 컴퓨팅 방식으로 통계학적 학습이 가능하다. 최근 스위스 취리히 대학교 뇌 연구기관 (Brain Research Institute of the University of Zurich)과 취리히연방공과대학 (ETH) 연구진들은 인공신경망 (CNN – Convolutional neural network)기술을 이용해 쥐의 뇌 기능 지형도를 나타내는 연구를 진행했다[참조 3, 4].

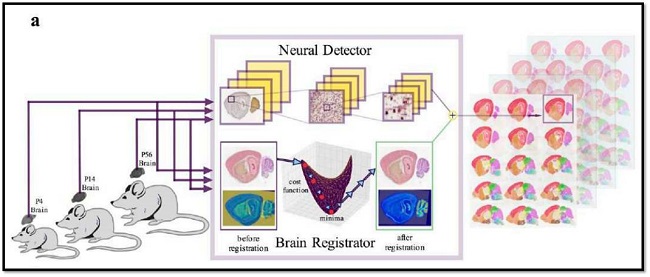

<그림2> 인공지능 기술을 이용한 쥐의 뇌기능 지형도 분석 시스템 [참조 3].

실험에서는 일반적으로 알려진 쥐의 뇌기능 지형도를 참조하여 인간의 통제를 최소화하면서 인공지능 스스로 뇌 지형도를 분석해나가는 딥러닝 방식의 시스템을 도입했다. 그리고 이를 이용하여 다양한 나이대의 쥐를 실험하며 정상 및 노화에 따른 뇌 기능 변화를 볼 수 있게 했다. 연구진은 이러한 실험을 더욱 발전시켜 나간다면, 현재의 어렵고 복잡한 방식의 뇌 지형도 분석법이 더욱 쉽게 이용될 수 있을 것이며, 결국엔 인간 두뇌의 조직 원리를 밝혀낼 수 있을 것이라 전했다.

2018년 5월 최근 국제 학술지 뉴런(Neuron)에 발표된 논문에서는 인간의 청각 기능을 모방한 인공지능 시스템이 소개됐다 [참조 5].미국 매사추세츠공과대학교 (MIT) 연구진들은 인간레벨의 음성인식, 음악 장르 인식이 가능한 인공지능 시스템을 최초로 개발했다고 전했다. 연구진은 실험에서 2초짜리 음성언어 클립 수천가지를 가지고 인공지능을 훈련시켰고, 음악 장르인식 실험 역시 2초가량의 음악을 가지고 훈련시켰다. 현실반영을 하기위해 음성파일에 잡음 또한 처리하지 않은 채로 적용시켰다. 결과적으로 인공지능 시스템은 인간과 같은 정도의 청각 인식 정확도와 오류율을 보였다.

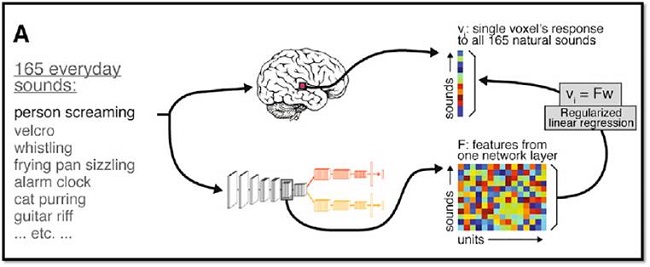

<그림3>자연적 소리에 대한 fMRI 반응 예측 모델[참조 5].

그리고 이 시스템을 통해서 두뇌 청각피질은 계층적 구조로 정보를 처리한다는 가설을 뒷받침할 수 있다고 전했다. 예를 들어, 간단한 정보처리는 상위 계층에서, 그리고 단어의 의미와 같은 고급 특징은 깊숙한 단계의 계층에서 단계적으로 처리한다고 한다. 연구진은 다음단계로 다른 청각과제를 준비하고 있는데, 이는 소리가 나는 위치를 밝혀내는 훈련을 진행할 것이라 전했다.

두뇌를 모방한 인공지능 시스템으로 인간의 뇌를 이해하려는 시도는 매우 흥미롭다. 1980년대 인공신경망 기술이 처음 개발되었을 때는 컴퓨터의 성능적 한계로 발전할 수 없었다. 그러나, 최근 들어 더욱 파워풀한 컴퓨터 성능과 최적화된 알고리즘을 이용해 다양한 분야에 실제 적용 사례들이 나오고 있다. 이러한 연구들이 계속해서 이어진다면, 멀지 않은 미래에는 우리가 알지 못했던 인간의 뇌를 완벽히 이해하고 활용할 수 있는 날이 오지 않을까 생각한다.

글. 송영제 한국뇌과학연구원 선임연구원 yjsong.bci@gmail.com

참조

[1]. Blausen.com staff (2014). “Medical gallery of Blausen Medical 2014”. Wiki.Journal of Medicine 1 (2).

[2]. M. F. Bear, B. W. Connors, and M. A. Paradiso, “Neuroscience: Exploring the brain,” 2007

[3]. Iqbal, Asim, Asfandyar Sheikh, and Theofanis Karayannis. "Exploring Brain-wide Development of Inhibition through Deep Learning." arXiv preprint arXiv:1807.03238 (2018).

[4]. Iqbal, Asim, Romesa Khan, and Theofanis Karayannis. "Developing Brain Atlas through Deep Learning." arXiv preprint arXiv:1807.03440 (2018).

[5]. Kell, Alexander JE, et al. "A Task-Optimized Neural Network Replicates Human Auditory Behavior, Predicts Brain Responses, and Reveals a Cortical Processing Hierarchy." Neuron 98.3 (2018): 630-644.